科大讯飞胡郁:A.I.+消费者=美好新世界

科大讯飞胡郁:A.I.+消费者=美好新世界

摘要

近日,在科大讯飞2017年度发布会上,科大讯飞执行总裁、消费者BG总裁胡郁发表了《A.I.+消费者 美好新世界》的主题演讲,对科大讯飞的人工智能如何服务消费者进行了详细阐述,详解了人工智能在翻译、移动、车载、家庭四大场景的具体应用,同时,发布了晓译翻译机1.0plus系统、译呗、讯飞输入法个性化智适应功能、飞鱼2.0系统、讯飞魔飞麦克风、脑电波控制家居等内容。

此前,科技部召开了“新一代人工智能发展规划暨重大科技项目启动会”,公布了首批4家国家新一代人工智能开放创新平台名单,科大讯飞及其他三家一同入选,其中就包含了明确依托科大讯飞建设智能语音国家新一代人工智能开放创新平台。科大讯飞执行总裁胡郁在会上发言表示,科大讯飞将通过一个开放创新研究平台、五大开放创新服务平台的建设路径,助力我国的智能语音及人工智能技术及应用达到国际领先水平。

以下为演讲视频完整版:

以下为演讲实录及PPT:

胡郁:大家好,顶天立地,A.I.赋能。刚才吴晓如总已经把A.I.和行业的结合能够给不同行业带来哪些变化向大家做了一些介绍,在行业层面,很多战略是需要从上而下推进的。但是人工智能的魅力绝对不限于此,人工智能可以非常接地气、可以面向消费者。

今天在座的,不仅有各行各业的专家,也有相对比较接地气的创业者、创新者和我们的用户。科大讯飞提出的“超脑计划”,不仅致力于服务我们的行业专家、知识和行业大数据的汇集,利用这些大数据和专家的系统方法改变行业;我们更希望探索,对于消费者来说,人工智能会带来怎样的影响,怎样改变我们产品的最终形态,以及它们和消费者之间的交互方式。接下来,让我们一起看看科大讯飞的人工智能技术是如何服务消费者的。

如何打造以消费者为中心的人工智能生态?

当今世界,已经不是一家公司单打独斗的时代了,我们都在说“生态系统”的概念——科大讯飞和我们广大的开发者和消费者其实在一个生态体系里。从这个角度来看,我们希望同时看到公司获得利润、消费者获得好产品、开发者获得乐趣。我们的终极目标是打造以消费者为中心的生态系统。

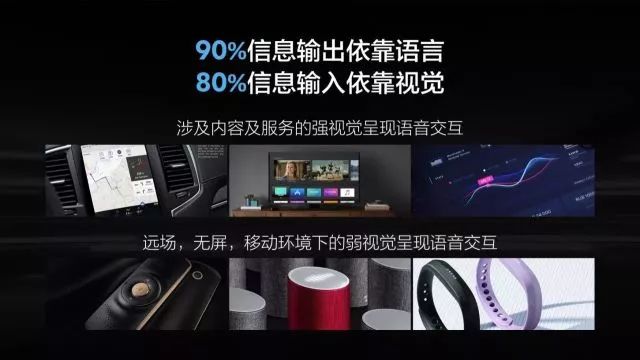

我们都知道,人类有80%的信息输入依靠视觉,然而90%的输出信息其实是通过语音。我们每天都在和各种产品进行交互,人工智能可以让我们的产品和人类更加自然地进行交互。于是我们发现,人机交互其实有个非常完美的组合——机器是有显示屏的,机器主要的输出内容正是通过显示屏;而正好人类大部分接受信息的渠道是通过看机器的显示屏得到的,人类的信息输出就是靠我们的语音,而机器现在正好能够理解我们的语音。

这样的一个人机交互体系:机器输出图像-人类接受图像-人类输出语音-机器接收语音,这样的闭环构成了一个非常重要的人机交互模式。在这种情况下,我们把它叫做强视觉呈现下的语音交互。与此对应的就像传统的打电话,我们也可以用纯语音的方式和机器进行交互,我们把这个叫做弱视觉呈现下的语音交互。

在过去的几年,我们一直按照这种交互方式的演变去建立我们的生态系统。研究这样的交互方式是非常不容易的,2010年我们第一次发布讯飞语音云平台以后,讯飞把源头核心技术创新做得越来越好,我们自己也打造了很多产品创新和应用创新。与此同时,我们也把整个开放平台面向广大开发者开放,他们在开放平台的基础上做了非常多的微创新。

科大讯飞的人工智能生态发展如何?

今天这个生态已经发展到什么阶段了呢?在过去的12个月当中,我们的开发者的数量从原来的23万涨到了46万,接入的设备数从原来的9亿台增加到现在的15亿台,我们提供的服务次数从原来的29亿次增长到40亿次,其中在线服务的数量更加惊人。所以我们可以看到,现在我们正在经历一个全新的时代,就是用我们的整个平台把我们的能力输出出来。

讯飞AIUI 1.0系统支持全双工交互,有非常先进的纠错能力,支持远场降噪、方言识别和多轮对话。利用AIUI 1.0的平台,我们向用户提供了很多内容,包括软件授权、解决方案和我们的用户界面。今天我们推出了AIUI 2.0的平台,在原来我们已有技术的基础上又增加了主动式对话、多模态交互、自适应、个性化识别等能力。为什么要提供这些能力?其实我们已经可以看到,在讯飞开放平台上,我们已经提供超过20多种包括语音识别、语音合成、声纹识别等不同的能力。我们也对用户在平台上的开发内容进行分析,提供面向智能音箱、会议系统、电子病历等不同场景的20多种的解决方案,并且这些解决方案全部面最重要的几十个场景开放。

这些场景中,主要包括翻译、移动、车载和家庭四大场景。随着我们在理论和工程实践上的不断进步,我们正在朝着一个目标前进,就是用iFLYTEK INSIDE来训练我们的产品。我们希望以iFLYTEK INSIDE为内核,希望这种自然交互方式能够成为越来越多、越来越广泛的消费者产品和人类的交互方式。

在我们的翻译场景中,语音担任了非常重要的地位。在移动场景中,我们所有的智能手机和它的附件,也是语音非常适用的展示场景。车载和家庭就不用说了,当前已经成为语音应用非常重要的展示场景。

A.I.+翻译场景=?

首先来看一下人工智能和翻译场景的结合。在去年的发布会上,我们发布了一个非常好的明星产品叫做晓译翻译机,晓译翻译机获得了广大用户的喜爱,也成为讯飞的一个代名词。

在过去的一年中,我们发现有产品有三方面需要改进。第一个就是在国外有时网络信号不是很好,甚至没有网络,这个时候晓译翻译机就没法用了。第二个问题是我们统计了使用携带晓译翻译机出国的人员,发现除了去英语国家以外,去说日语、韩语、法语和西班牙语的地区的人数加起来超过了总出国人数的80%。所以说这些语言翻译的需求也是非常迫切的。第三个问题是现在出国的人员除了需要语言的翻译以外,最迫切的刚需是什么呢?是人身安全。国外一些地区也存在恐怖袭击、犯罪侵害等情况。用户在这个时候其实非常需要紧急联络的渠道和神器。

在这些需求的基础上,今天我们发布讯飞晓译翻译机1.0plus系统。其中第一大创新就是我们将现在世界上最先进的神经网络翻译系统,从原来的在线系统优化成一个离线系统,并放在翻译机小巧的载体内,让它可以在无媒甚至没有网络的情况下也可以提供基本的翻译服务。其次,我们也增加了中文和日语、韩语、西班牙语、法语之间的在线翻译。这样80%的出国人员可以在各种各样情况下使用我们的翻译系统。第三个是我们发布的一个重点,我们在晓译翻译机1.0plus的背后设置了一个SOS的紧急联络按钮。当我们在遇到紧急情况的时候,按下键三秒钟,我所在的位置就会在我们后台专业服务中心的大屏幕上呈现出来,同时还可以接通你紧急联系人或者大使馆的电话。

是不是有了晓译翻译机我们就不需要学英语了?我们对很多晓译翻译机用户做了一项调查,发现很多父母非常喜欢带自己的小孩去国外旅行。因为在那种场景下,孩子更容易在一个自由的语言环境中进行学习,而且他们希望自己能够学会英语以后,实地跟外国人进行交流。因此我们针对这种要求,特地开发了世界上第一款能够对孩子进行英语教学的学习机,叫做译呗。译呗有什么功能呢?通过分析我们过去卖出20多万台的学习机,一次的使用中最常用的3000个对话场景,这个对话随着我们的使用会不断更新,同时它还内置了将近13000种常用的中英文对话。在这个过程中,我们就能够非常便捷根据我们设身处地的情况,教会孩子们一些常用的语句。

讯飞作为AI翻译的开拓者,我们一直也在思考有没有用更加轻松的办法来进一步实现我们的翻译?我的答案是肯定的。今年科大讯飞就给大家带来在翻译领域全新的技术体验,就是AIUI的全双工翻译系统。通过这个系统,我们不需要做任何的按键,甚至身上不用戴任何的设备,只需要通过借助外部的设备,就可以帮我们来实现自由的翻译。

阿尔法蛋系列是今年的中国智能玩具的销量冠军。除了阿尔法大蛋以外,最近马上还要推出超能蛋和英语蛋。我们整个的智能语音交互和智能语音全双工翻译的功能,也很快会在阿尔法蛋进行上线。

A.I.+移动场景=?

刚才我们看到了讯飞的全双工语音交互的场景在翻译场景下如何使用,在移动的场景下,我们有什么样新的产品?

2010年科大讯飞第一次推出了讯飞语音输入法,这是业界第一次将语音输入和输入法结合在一起。在过去的八年发展中,我们已经聚集了5亿的用户,每个月的月活用户超过了1.2亿,而且根据我们今年最新发布的识别引擎,我们在通用场景下的识别正确率已经达到了98%。很多人都问识别率都已经98%了,还能有进一步提高的空间吗?

我们仔细分析了一些用户的反馈,在输入的过程中,因为语音会受到各种各样因素的干扰,针对用户的需求,我们又对现在所有输入法的用户进行了深入的分析。在我们分析的人群当中,我们发现在98%的人群中有23%的人,他们的发音平均效果是没有达到百分之百的。我们还发现更多的人可能根本就没有使用我们的语音输入法,为什么?因为他们觉得自己的口音不好;语音识别效果不好的主要原因呢?一方面是口音的问题,方言口音可能太严重,另外一方面就是跟专业词汇有关。我们也一直在思考解决这个问题。

今年我们在业界第一个推出了语音个性化,通过声学个性化和语言个性化来提升每个人的识别的效果。在过去的一年当中,我们已经进行了灰度的内测,在600万的粉丝用户中,我们发现通过个性化的这种方式可以额外提高20%以上的系统性能效果。

通过什么样的算法才能实现语音修改的功能?这是一个非常有难度的挑战。大家都知道原来传统的语音识别,其实是我们对所有人适用的同一个引擎,服务调度比较容易进行;而用了声学个性化技术以后,我们需要为每一个单独注册用户他提供一套单独的识别引擎,用原来传统的构造是完全没法做到的。大家看到刚才的响应速度非常快,达到了毫秒级,我们在这个过程中做了算法优化、工程优化、架构优化三个方面的技术,并且将自主学习个性化语言模型和识别结果的优化综合起来,形成了我们基于Cache based Fast Adaptation的技术,我相信这也是业界乃至全球第一个能够进行语音修改和快速智适应的技术。在前天晚上坚果pro的发布会上,锤子科技的朱萧木副总裁也演示了语音修改这个功能,但是大家看到的其实是整个功能的一个部分而已,真正的是我们个性化自学习的功能。

这个过程我们是怎么做到的呢?技术的核心在于个性化智适应。也许大家会问,为什么其他输入法并不具备这个能力?其实很简单,首先从技术上来讲,个性化自主学习、个性化语言模型和优化识别都需要基于一种全新的技术层面的个性化方案,在技术研究上本来就有难度。但是还有一个更大的难度是工程上的,原来我们的识别引擎对所有人开放的结果都是一样的,对于上亿的人在不同的服务器上调度非常容易。但是现在,我们要给百万级甚至千万级的用户、每个人要做一个识别引擎。在算法优化方面,我们把资源利用率提高了一百倍,在工程优化方面,我们把吞吐量提高了50%,在架构优化方面我们又把效率翻了一番。只有在这种情况下,我们才能够给在座的所有的每个人建立一个独一无二的输入引擎。

A.I.+车载场景=?

我们还有一个移动的场景是什么?是车。其实在过去的几年当中,车载是我们第一个爆发的点。为什么?因为对车而言,安全太重要了。我们在去年发布了飞鱼系统,飞鱼系统以及它的前辈们已经被卖出一千多万套以上,活跃的用户超过了400万户。这里面还有一个惊人的数字,就是月活跃率达到了90%。大家知道在手机上一个软件月活跃率达到90%什么概念吗?只有一个软件做到了,就是大家正在用的微信,所以大家可以想象一下,语音在车载环境下是多么重要。

车载的具体的环境里还分为很多细节的场景,比如说上车说车开动,比如说开车过程中再到你离开车,现在大家的需求已经不简单是操作就可以了。更多人希望车能更了解我、我的性格,车能知道我喜欢什么;他们还希望信息化系统能够更懂车。那么车是不是可以跟更多设备连接在一起,包括手机、智能家居?

今天,我们在这里发布飞鱼2.0系统,飞鱼2.0系统的宗旨就是更懂我,更懂车,更互联。

我们是怎么做到让车更懂你的?很简单,将后台的账户系统、用户所有的大数据收集起来进行分析,在分析的基础上就知能得知驾驶员的爱好是什么、他太太的生日是哪天、他的最喜欢的菜是哪一种、他更喜欢看哪一种类型的电影。只有有了这些信息,车载信息系统才能发起一次主动的询问,这一点非常重要。因为传统上都是人先发问,那是因为我们知道自己的意图;而如果我们的车辆系统能够知道你的所有、猜测你的意图,并且做出主动发问,这就使我们真正进入了双向互动的时代。

如何更懂车?大家都知道,现在车辆的说明书更新得非常频繁,那么多的内容怎么手工地一条条增加?其实这里我们就用到了刚才刘庆峰董事长介绍的,在SQuAD国际机器阅读理解权威评测中用到的技术,我们让这个信息系统自己去读说明书。我们的车载自动说明书就是为了解决大家的困境,当说明书被车载系统读了以后,就会自动形成自己的知识体系。当我们询问这些知识时,它就能用最快的速度反馈。

只要车载的飞鱼系统和车的总线系统连接以后,不仅仅是车窗、空调这样的事情,包括氛围灯、后视镜、座椅前后的调整,全部都可以用语音来进行。将来在生活当中我们的场景是相互连接的,我们的手机、车载、家庭,应该无缝连接在一起。我们将来给大家带来的车联网,不仅可以更懂我、更懂车,而且可以深度链接。

今天我们要推出全新的“小飞鱼”。我们不仅仅是把飞鱼系统变小了,而是让小飞鱼可以直接在车上使用。我们把所有的功能浓缩到一个像小飞碟一样的外设里,这个小飞碟只要放在你的车上,就会通过蓝牙设备和你的手机里的车机进行连接。我们通过它,不仅可以打电话发短信,还可以导航、听音乐台、播放本地的音乐。这也是我们将前十几年来在车载上取得的各种经验浓缩其中的一个产品。

A.I.+家居场景?

在前面的场景中,语音确实出现了表现出它独一无二的特性。我们将来想往什么地方去?我们将来想往家庭去。

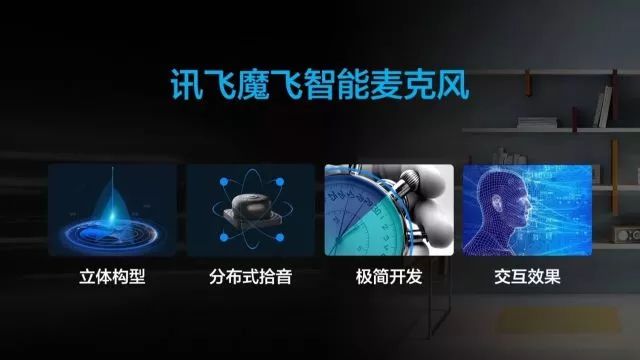

因为家庭场景最复杂,一个房子有很多房间,我们在不同的房间里面怎么使用语音是非常大的挑战。在过去的几年当中,我们一直尝试在智能家居中使用语音交互系统,但发现有非常多的挑战,第一个是技术难度很大,因为家庭是开放的空间,不像手持设备或是封闭的车内。第二,开发周期特别长,我们的开发伙伴有专注智能家居的,前前后后用了大半年的时间,才把我们的系统整个调优。第三个挑战就是声学特性比较难,大家都知道在家庭里经常是几米远的距离。最后一个就是场景的局限性,我们都知道如果房间很大,到底是放一个独立的设备还是把很多麦克风阵列放在各个家电中,这个问题一直没有得到很好的解答。

今天,经过我们多年在工程设计、技术体验和从最终用户的角度出发进行产品设计的基础上,我们推出了讯飞魔飞麦克风,这是专门为我们家庭环境下特定设计的系统。讯飞魔飞麦克风采用了独特的双层八麦克风的设计,在家里不仅可以摆在桌子上,也可以放在墙壁上,甚至可以吊在天花板上。在开发时间这个难题上,我们配合AIUI 2.0的整个开发系统,现在只要一个小时,就可以把整套系统上线。

最后一个难题针对用户体验,讯飞魔飞麦克风已经把整个麦克风阵列、硬件后台的芯片以及云计算整合在一起,所以可以保证用户得到最好的体验。除此之外,我们发现在家庭环境中还有一个需求,就是大家已经不满足于只用嘴来控制家居,用手势、形体也可以来控制智能家居,有没有可能把这些多模态的控制整合在一起?今天我们就带来了科大讯飞面向智能家居的新的整体解决方案。

在家庭中一般都有多个人员身份,通过声纹的方式就可以快速地识别出谁是谁。在这个过程中,只要你注册了声纹,那么系统就能够把你个性化的资料完全存储下来,刚才我们说的主动式提问等一系列的工具就都可以在家庭里面使用。

我们可以用手势来控制家居,而当画面上出现一大片的电影进行备选时,这些电影的名称会被马上上传到我们的服务器,并且在我们的识别网络中构建出一个实时的识别网络这样我们在说出电影的任何一个名字后,就可以立刻进行匹配。这就是我们说的强视觉呈现语音交互的内容。当你看到所有的内容后,你立刻可以说出来进行控制,也就是我们说的所见即可说。

打通了整个认证的体系,并将声纹和人脸整合在一起,就能实现一个非常高效、有保证的、安全的保障体系。现在大家的工作都特别繁忙,在座的很多人可能每年有一半的时间都不在家里,我们怎么谈家庭生活?用我们最先进的智能家居,能不能把大家带回家庭里去?

首先,使用我们的远程麦克风阵列,我们可以保证你在家里的任何地方都可以直接和另外一端进行视频通话,真正的解放你的全身。是不是我们也就到此为止了?有很多人说我想连脚趾头都不动,就可以操纵家里的电器、叫外卖、看电影,你别说,科大讯飞还真做了这种技术!目前我们开发出了新的脑电波控制家电的技术,大家可以在现场的演示中看到,产品经理佩戴上了特殊的装置,并且保持身体与控制界面完全没有接触;通过全神贯注地思考,控制界面上依次显示出“打开电灯”、“打开加湿器”、“打开窗帘”的指令,并完成了智能家居的一系列对应操控。

【脑电波控制家电技术现场演示】

这项技术是我们华南理工大学-讯飞联合实验室开发出的,在世界上处于前瞻性的地位。但是它进入我们的家庭还需要一段的时间。

A.I. ALL FOR YOU

人工智能已经用AIUI2.0改变了生活中很多的东西,我们最希望做到的是什么?我们希望科大讯飞的人工智能——A.I. ALL FOR YOU。这代表了很多人员,代表了我们的行业合作伙伴,代表了我们的开发者,也代表了我们的用户。

它到底能为你做什么?首先,它能帮助你沟通无界,增强人际之间的交流交互,让你连接无限。我们正在进入一个无所不联的物联网的时代,可以连接我们与不同场景,最后它也可以让我们想象无边。人使用交互背后需要的是什么?是场景式服务,所以我们将来的想象空间还会无所不在。

最后我想和大家分享一下科大讯飞18年的心路历程。一开始很多人都笑话我们做的事,但大家没有看到语音产业背后的实质是人工智能。在一开始的时候,也许我们并不知道自己追求的是多么伟大的一件事情,但是我们坚持下来了。我们经常说一句话来激励自己:你所清楚预见的、热烈渴望的、真诚追求的,都将自然而然实现!让我们一起在中国用人工智能改变世界,谢谢!

文章来源:科大讯飞

编辑:徐蕾